TOP

視野拡張のためのマルチカメラ統合型SLAM

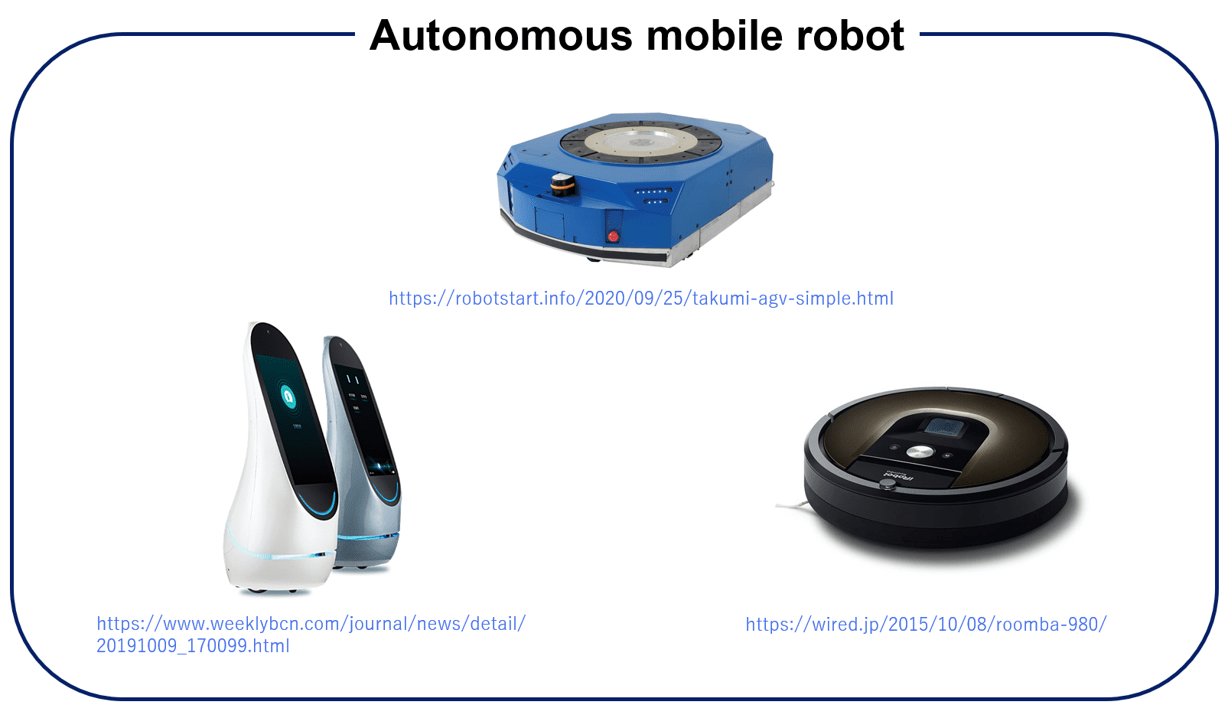

近年、自律移動ロボットは、工場で活躍する搬送ロボット、施設で活躍するサービスロボットなど、多岐にわたる環境・用途で利用されています。

これらは社会的問題とされる少子高齢化に伴う労働力不足の解消や、作業の自動化による省力化・効率化に貢献しています。

実用化を考えた場合、 自律移動を安全かつ正確に行うために高精度なSLAM(Simultaneous Localization and Mapping)が求められます。

SLAMとは自己位置推定と環境認識のための地図構築を同時に行う技術の総称です。

SLAMに用いるセンサは低コストであることが望まれます。

センサにはカメラ(単眼、ステレオ)やレーザ測域センサ(Lidar:Light detection and range)などが用いられますが、コスト面を考慮するとカメラの方が望ましいです。

カメラを用いたSLAM(Visual SLAM)には、特に単眼カメラを用いた場合、距離の単位(スケール)が推定できないという問題があります。

最近のVisual SLAMは、深層学習ベースの手法が拡大しています。

右の動画のように広大な屋外環境でもほとんど正確に位置推定が可能となり、同じ位置に戻ったときにも地図が歪まずに正確な地図構築が可能となっています。

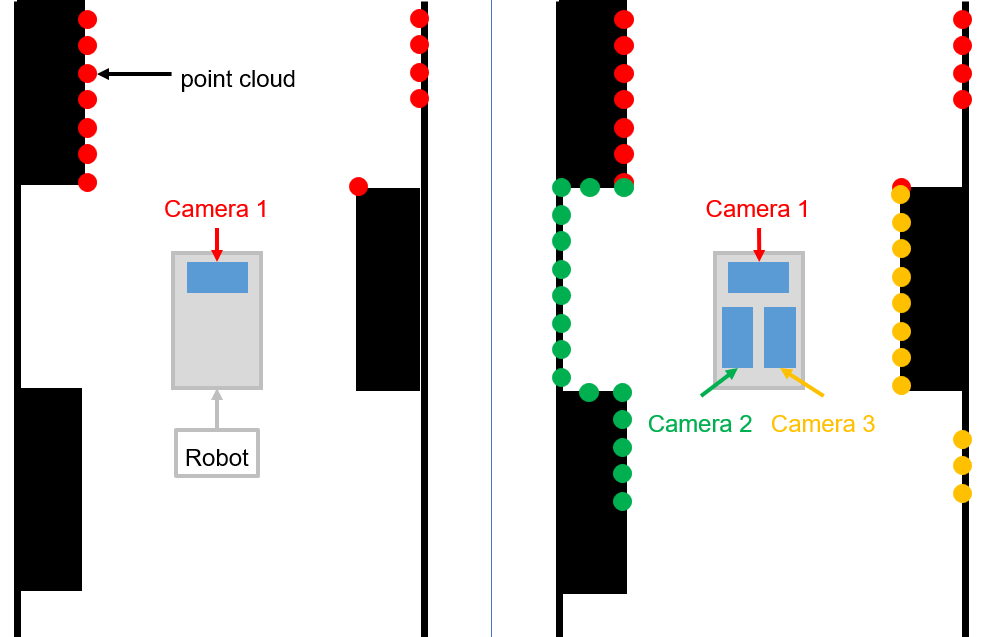

本研究では、複数カメラを連結して視野を広げたSLAMを提案します。

左の図のように、カメラをロボットの進行方向に一台しか用いなかった場合、点群の地図は進行方向にしか現れなくなります。

しかし、複数カメラを用いた場合、点群の地図をより広範囲に取ることが可能となります。

特に、移動ロボットが周回して同じ場所に戻ったことを検出して、その位置を合わせてループを閉じるようにするシステム(ループ閉じ込み)をより作動しやすくなります。

実験環境は、Gazeboシミュレータのシミュレーション実験と実機のカメラを用いた実機実験を想定しており、従来のカメラ一台のみを用いたVisual SLAMの根本的な問題を解決しようと考えております。

研究の担当者

M2

足立一貴

M1大竹悠也

B4加藤優士

B4坪内勇斗